COMO O YOUTUBE SE TORNOU UM CELEIRO DA NOVA DIREITA RADICAL - Yasodara Córdova - 10 de Janeiro de 2019 - POR: INTERCEPT BRASIL

COMO O YOUTUBE SE TORNOU UM CELEIRO DA NOVA DIREITA RADICAL

Ilustração: Rodrigo Bento/The Intercept Brasil

RESOLVI FAZER UM experimento. Com um navegador recém instalado, abri o YouTube e cliquei em um vídeo sobre as máquinas de forjamento de martelo mais rápidas e pesadas que existem. Deixei o sistema rodar mais 13 vídeos na sequência, assistindo aos vídeos, sem deixar likes ou fazer login. A ideia era ver quais eram as sugestões que o YouTube recomendava depois do primeiro.

Após passar por vídeos de halterofilismo, corte de árvores e muitos anúncios de ferramentas pesadas, equipamentos e carne para churrasco e outros, o YouTube me recomendou um vídeo sobre como fazer munição para uma arma semi-automática.

As recomendações e os anúncios, voltados para quem exalta o estilo de vida do Rambo, mostram que os algoritmos entenderam que, porque eu cliquei em um único vídeo de máquinas pesadas, eu sou homem e gosto de armas e churrasco.

Essas conexões que os algoritmos fizeram vêm dos dados que o YouTube analisou sobre meu comportamento no site e sobre os vídeos com os quais interagi, seja clicando sobre o vídeo, pausando, aumentando o volume ou até mexendo o mouse sobre as recomendações. Tudo é monitorado. As métricas que escolhem quais vídeos serão recomendados são baseadas, principalmente, na possibilidade de um vídeo ser assistido pelo usuário. Ela faz parte de um mecanismo sofisticado de inteligência que tem um objetivo principal: fazer com que você passe o máximo de tempo possível no YouTube.

Como conteúdos extremistas naturalmente chamam mais atenção, a plataforma cria uma bolha conectando vídeos bizarros. Assim, usuários mergulham cada vez mais fundo num assunto. Não por acaso, da fabricação de martelos eu fui levada pelo algoritmo para um vídeo sobre munição e armas em apenas 13 passos. A mesma coisa acontece com vídeos relacionados à política.

Recomendação ao extremo

Em 2015, os usuários do YouTube subiam 400 horas de vídeo por minuto. A maior parte desse conteúdo é criada de forma amadora. No site, usuários de todo o mundo gastam mais de um bilhão de horas assistindo a vídeos todos os dias.

Apesar de ter um serviço de assinaturas, o YouTube Premium, o serviço ganha dinheiro mesmo é com anúncios. Para sustentar a infraestrutura necessária – e garantir que o modelo continue crescendo – o site precisa ser gigante. Como na velha TV aberta, quanto mais pessoas assistindo a um programa, mais gente vê os comerciais durante os intervalos.

Para manter o interesse das pessoas nos canais – e garantir que elas sejam expostas a mais e mais anúncios –, a plataforma usa algoritmos para organizar o conteúdo e circular vídeos novos, gerando uma demanda diária por novo material. Esses algoritmos usam uma combinação de dados para recomendar vídeos que visam, literalmente, prender e viciar as pessoas.

Quando o sistema de recomendações foi lançado, em 2010, ele deu resultados imediatos: começou a ser responsável por 60% dos cliques dos usuários, segundo artigo científico escrito pelos cientistas do Google no mesmo ano.

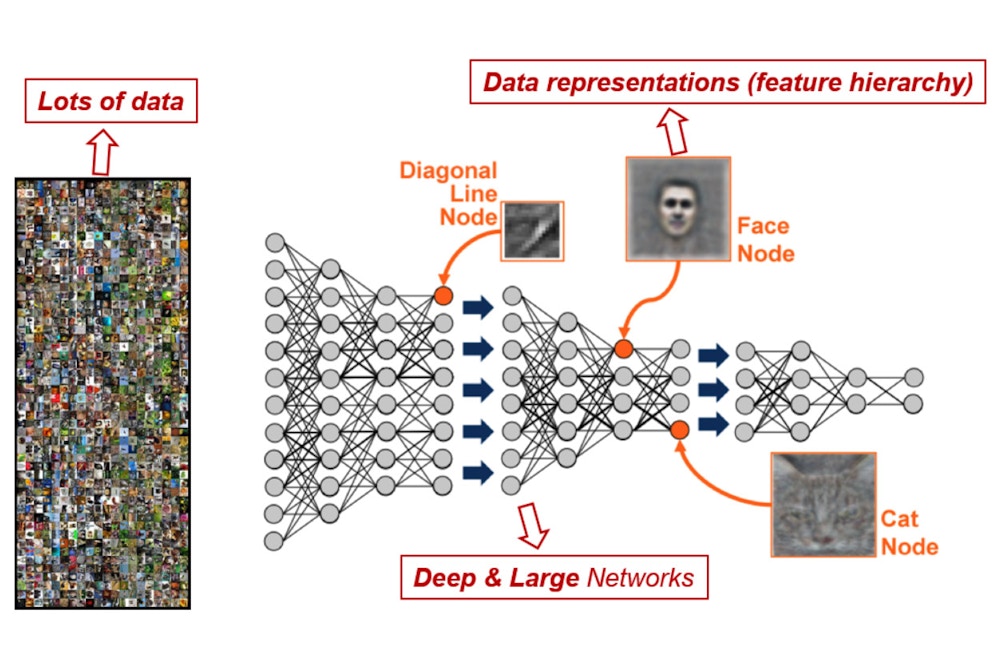

Em 2015, com a liderança do time Google Brain, a empresa começou usar aprendizado de máquina – conhecido em inglês como machine learning – para melhorar o sistema de recomendações. Em 2017, o YouTube começou a rodar tudo sobre uma sofisticada plataforma de inteligência artificial, o Tensorflow.

Estava completa a transição para um sistema que aprende sem ser “supervisionado” por humanos – tecnologia também chamada de unsupervised deep learning, ou aprendizado profundo sem supervisão. Esses algoritmos escolhem quais vídeos vão para a barra de recomendados, quais aparecem na busca, qual vídeo toca a seguir quando no modo reprodução automática (o autoplay) e também montam a homepage dos usuários no YouTube. Sim, cada vez que você abre sua home ela está diferente. Ela foi customizada pelas máquinas para que você assista mais e mais vídeos.

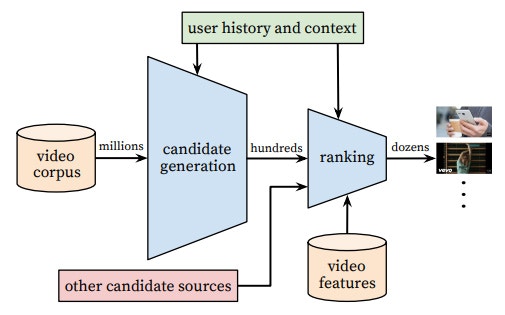

Para tomar as decisões por você, os algoritmos associam significados que eles mesmos aprendem em etapas, de modo a filtrar e combinar categorias para chegar em um conjunto de vídeos ou anúncios para recomendar. Primeiro, dão um significado para um vídeo segundo suas características. Depois, combinam esse significado com mais dados, como por exemplo a quantidade de horas que um usuário gasta assistindo determinados vídeos com significados semelhantes. As categorias vão sendo combinadas pelos algoritmos para encontrar as recomendações que o usuário tem mais possibilidade de clicar e assistir:

O site gera essas recomendações a partir das suas interações, nas informações dos vídeos e nos dados dos usuários. Isso engloba tudo que você faz no navegador: parar o vídeo, colocar o mouse por cima de determinada imagem, aumentar ou diminuir o volume, quais abas você está navegando quando está vendo vídeos, com quem você interage nos comentários e que tipo de comentários faz, se deu like ou dislike e até mesmo a taxa de cliques em recomendações etc.

Gráficos mostram a arquitetura do sistema de recomendação demonstra o ‘funil’ que classifica os vídeos para o usuário.

Como a interação não é só baseada em likes, o YouTube valoriza também os comentários, atribuindo valores de positivo e negativo às conversas. Por causa disso, o feedback do usuário sobre o vídeo é avaliado e pesa na fórmula que calcula a possibilidade da pessoa assistir aos outros vídeos. Mesmo sem dar like, você entrega os seus dados e tem sua interação monitorada o tempo todo.

Os autores dos vídeos sabem muito bem como funciona essa lógica. Os anunciantes também. Os youtubers têm à sua disposição a plataforma para criadores do YouTube, o YouTube Studio, que fornece métricas e informações sobre a audiência. Assim, existe um incentivo para os produtores fazerem vídeos cada vez mais extremos e bizarros para prender a audiência o máximo possível. Isso explica um pouco a obsessão da internet pela banheira de Nutella, e também ajuda a entender como se elegeram tantos youtubers interconectados nas últimas eleições.

Como conteúdo radical dá dinheiro, por conta dos anúncios, extremistas usam também outras ferramentas para incentivar a formação de bolhas e atrair cada vez mais gente. No Brasil, donos de canais de conteúdo extremo e conspiratório, como a Joice Hasselmann, por exemplo, costumam divulgar seu número do WhatsApp, viciando as pessoas em seus conteúdos com base na exploração dessa relação de proximidade ou intimidade.

Redes de extrema-direita

Enquanto o Google terminava a transição da sua tecnologia no YouTube, surgiram denúncias sobre como vídeos de conteúdo extremo começaram a ganhar audiência na plataforma – muitos deles, inclusive, recomendados a crianças. Em 2017, pesquisadores descobriram uma rede de produtores de conteúdo que fazia vídeos com conteúdo bizarro para crianças: afogamentos, pessoas enterradas vivas e outros tipos de violência eram empacotados com música e personagens infantis.

Alguns pesquisadores, como a americana Zeynep Tufekci, escreveram sobre como o YouTube estava lhe recomendando conteúdos da extrema direita americana após ela ter visto um único vídeo de Donald Trump. No Brasil não é diferente. Basta assistir a um vídeo de extrema direita que as recomendações vão garantir que você se aprofunde cada vez mais no ódio:

Vídeo de Kim Kataguri “puxando” o fio de outros vídeos extremistas, com direito a anúncio do Trump e tudo.

Foto: Reprodução/YouTube

A radicalização acontece muito mais à direita do que à esquerda. Primeiro porque os produtores de conteúdo conservadores souberam bem agregar pautas polêmicas e teorias conspiratórias que já faziam sucesso na internet, como o criacionismo. Além disso, há uma coerência em suas pautas – os assuntos em comum ajudam a alavancar a audiência de forma mútua. Já a esquerda, além de ter uma pauta mais fragmentada que nem sempre se conversa – há o feminismo, a luta antirracista, os marxistas etc –, não conseguiu surfar a onda das polêmicas de internet.

Guillaume Chaslot, que é ex-funcionário do Google e hoje trabalha em uma fundação para a transparência de algoritmos, tem argumentado desde 2016 que a plataforma de recomendações do YouTube foi decisiva nas eleições de Trump, espalhando notícias falsas e teorias da conspiração. Segundo ele, o algoritmo vendido como neutro pelo Google ajudou a garantir audiência para vários vídeos conspiratórios, como um em que Yoko Ono supostamente admitiria ter tido um caso com Hillary Clinton nos anos 1970 e outro sobre uma falsa rede de pedofilia operada pelos Clinton.

O impacto desse tipo de conteúdo, porém, não é fácil de ser medido – a fórmula dos algoritmos é mantida em segredo pela empresa, ou seja, não dá para saber exatamente quais são os critérios que determinam o peso de cada característica no processo de decisão sobre qual vídeo indicar.

ESSE SISTEMA cria uma rede interligada – que, em conjunto, fica mais poderosa. Analisando mais de 13 mil canais de extrema direita no YouTube, Jonas Kaiser, pesquisador do Berkman Klein Center de Harvard, percebeu que elas estão conectadas internacionalmente dentro do YouTube, especialmente por conta do compartilhamento de vídeos com idéias extremistas. É uma rede fértil para circular a ideia de que políticas afirmativas para negros são parte de uma conspiração para acabar com a raça branca ocidental, por exemplo, o delírio de que vacinas são parte de um plano para acabar com determinadas populações em um experimento ou até a história de que as eleições brasileiras estariam em risco por uma suposta fraude nas urnas eletrônicas.

Os dados levantados por Kaiser mostram que o esquema de recomendação do YouTube “conecta diversos canais que poderiam estar mais isolados sem a influência do algoritmo, ajudando a unir a extrema direita”, ele escreve.

‘A plataforma de recomendações do YouTube foi decisiva nas eleições de Trump, espalhando notícias falsas e teorias da conspiração.’

Não é por acaso que o teor conspiratório dos vídeos dos EUA é bem parecido com as redes de outros países: quase sempre envolve vacinas, terraplanismo, pedofilia e uma suposta organização internacional de esquerda sedenta por tomar o poder.

No Brasil, o cenário não é muito diferente. Temos a nossa própria rede de influenciadores de extrema direita, catapultados para a fama com a ajuda do algoritmo do YouTube. Nando Moura, com quase três milhões de seguidores, já fez vídeos defendendo a existência da cura gay. Outro influenciador, Diego Rox, defende para seus quase um milhão de seguidores a existência da Ursal. Todos recomendados por Jair Bolsonaro, que se beneficia da popularização de teorias conspiratórias de extrema direita.

Recentemente o Google reconheceu o problema. A empresa disse que passaria a sinalizar vídeos que espalhassem desinformação e exibiria, junto com eles, conteúdo da Wikipedia, em uma medida que pareceu um pouco desesperada. E não ataca a raiz do problema: seu modelo exploratório de negócios, uma herança da televisão.

A verdade é que o YouTube é um grande laboratório de machine learning, onde os seres humanos são as cobaias. Resta saber qual é o real impacto do experimento no exercício da liberdade de escolha e expressão. O problema é que eu desconfio que algo não está dando muito certo.

Comentários

Postar um comentário